满血版DeepSeek上线武汉大学!快来解锁高阶玩法!

智能总结

智能总结武汉大学信息中心成功完成DeepSeek 全系大模型的部署调试

新学期伊始

武汉大学信息中心成功完成

DeepSeek 全系大模型的部署调试

本地化服务将有效保障

科研数据隐私与信息安全

支持灵活的定制开发和算法优化

云端调用充分利用公有云强大的AI算力

支持更加复杂的推理任务和应用场景

大模型包括哪些?

DeepSeek-R1-14B

中型规模模型

适合一般性的自然语言处理任务

DeepSeek-R1-32B

大规模模型

提供更广泛和深入的对话与推理支持

DeepSeek-R1-671B和

DeepSeek-V3-671B

云端满血模型

适合需要深度推理的任务

Qwen-14B

高效的语言生成能力

适用于文本创作、代码编写等多种场景

如何使用?网页端

访问https://aiop.whu.edu.cn/aiop/#/

登录后即可使用

移动端

打开智慧珞珈APP

点击“应用中心-公共服务-AI智能体平台”

登录后即可使用

还有什么高阶用法?

除提供随手可用的智能体应用外

借助强大的算力底座

武汉大学超算中心还支持

用户自行部署并运行DeepSeek

等各类开源大模型

深度探索大模型的部署

训练和推理应用

以支持更加专业的科研需求

如果你已经开通了超算中心账号

并且具有GPU的计算权限

那么快来学习如何操作吧!

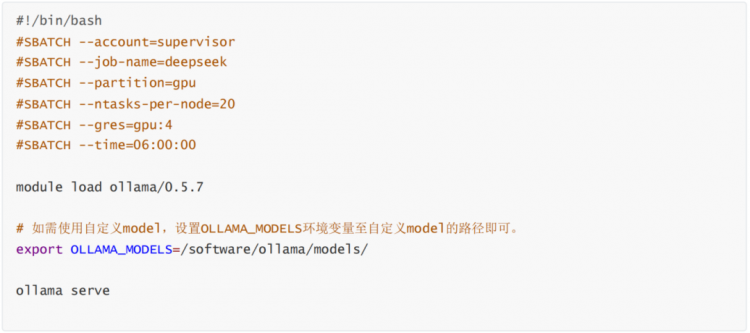

在超算集群上运行DeepSeek

首先创建一个作业脚本

将以下文本粘贴到作业脚本中,然后保存文件

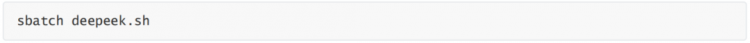

将此脚本作为作业进行提交

现在,检查您的作业是否正在运行

确定作业已启动后,通过 ssh 登录已分配的计算节点

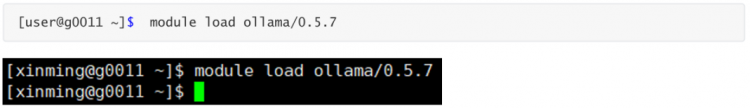

SSH 登录计算节点后,加载 ollama

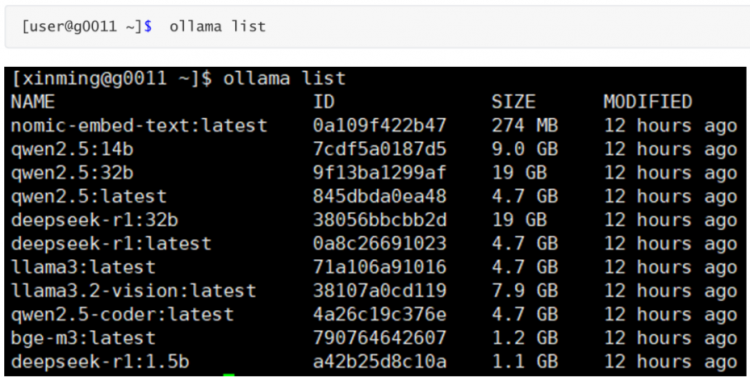

SSH 登录计算节点后,列出所有模型

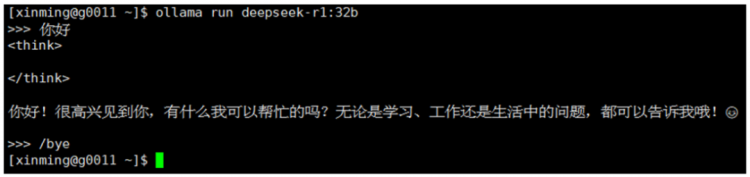

SSH 登录计算节点后,运行 deepseek-r1:32b

特别提醒

模型路径:如果想使用自己的大模型,设置OLLAMA MODELS环境变量至自定义model的路径即可。

节点选择:对于 32B 以上的大模型,建议使用 A100 节点以获得更好的性能。

资源需求:根据具体需求调整作业脚本中的资源请求(如 GPU 数量、CPU 核心数等)。

(本文转载自武汉大学MBA和EMBA ,如有侵权请电话联系13810995524)

* 文章为作者独立观点,不代表MBAChina立场。采编部邮箱:news@mbachina.com,欢迎交流与合作。

热门推荐

备考交流

最新动态

推荐项目

活动日历

- 01月

- 02月

- 03月

- 04月

- 05月

- 06月

- 07月

- 08月

- 09月

- 10月

- 11月

- 12月

- 05/06 活动报名 | 经济学教授x帆船奥运冠军x独角兽企业联创,聊聊个体与组织的双向奔赴

- 05/07 活动预告 | 节后活动不停歇,5月7日招生直通车开启预约,CLGO毕业校友、知名跨国消费电子企业学长经验分享即将到来!

- 05/08 颠覆性创新时代,一切『再设计』| 复旦-BI MBA《设计思维》公开课报名

- 05/10 全球经济格局变化与中国的应对策略 | 复旦MPAcc公开课报名

- 05/10 重磅抢位!中欧MBA年度健康产业论坛2025:医疗创新为本,领航易变时代

- 05/10 报名|就读一年开启创业之路!交大TFMBA学长与你相约招生开放日

- 05/10 长江商学院MBA公开课|大厂专题:多元竞争,突破增长瓶颈 @北京

- 05/10 【招生沙龙报名】把握AI时代机遇,复旦MBA助你职场进化

- 05/17 【华东理工大学商学院iBEST融合创新系列论坛】应变而进:全球政策变革与企业全球化战略转型

- 05/17 【重磅开启】2026年入学同济经管专业学位招生发布会邀您参加!

热门资讯

MBA院校号

暂无数据